#ジェスチャー

Text

TEDにて

ジェイミー・ペイク:自ら形を変え変身する折り厚板紙ロボット

(詳しくご覧になりたい場合は上記リンクからどうぞ)

板金やチタン合金?セラミック?

折り紙からデザインのヒントを得てロボット開発者のジェイミー・ペイクと彼女のチームは、非常に薄い素材を折ってできたロボットで自ら形を変え変身する「ロボガミ」を創り出しました。

このトークと技術デモでペイクはロボガミが地上や宇宙で様々な作業をこなすためにどう適応できるのかを示し

丸まったり跳んだりパチンコのように射出したり、更には心臓の拍動のように脈打ったりする様を実演してお目にかけます。

ロボット開発者としてよく聞かれます「ロボットが朝ご飯を作ってくれるようになるのはいつか?」

未来のロボットは、人間の姿に近づくのではないかと考えました。自分に近い容姿になると考えたので自分の目を模倣した目を作成しました。

物を私に渡せるように、器用な指を作りました、野球のボールとか。

こちらのような古典的なロボットは、決まった数の関節と駆動装置で構成され機能します。このことが意味するのは、機能と形状は構想の段階で確定してしまうということです。

このロボットアームに素晴しい投球ができカメラの三脚に当てさえしたとしても朝ご飯を作ってくれるわけではありません。

スクランブルエッグを作るのには向いていないのです。これが、未来のロボットのビジョンを思いついた瞬間です。

変形ロボットです。車のように走り人のように駆け、鳥のように飛び、新しい環境とその時の作業に合わせて変形します。

これを実現するためにロボットデザインの方法を考え直さねばなりません。

多角形型のロボットモジュールがあるとしてその単純な多角形を使って様々な形を再構築して異なる作業向けに異なる形のロボットを作り出すことを想像してください。

コンピュータグラフィックスでは、目新しいことではありません。かなり前から多くの映画がそのように作られています。

でも物理的に動くロボットをそのように作ろうとするならまったく別の新しい話で、まったく別のパラダイムで意外と難しい。

でも皆さんは、既にやったことがあります。紙飛行機や紙の船や折り鶴を作ったことのない人は?

折り紙はデザイナーにとって万能の道具です。一枚の紙から様々な形状を作ることができ、もし気に入らなければ広げてもう一度折り直せます。

折ることで二次元の面からどんな三次元の形でも作れ、そのことは数学的に証明されています。

もし知的な紙があって自律的に折り上がり、求めるどんな形にもいつでも変形できるとしたらどうでしょうか?

それこそが私の取り組んでいることなのです。私はこの折り紙のロボットを「ロボガミ」と呼んでいます。

これが最初のロボガミの変形の様子です、私が10年くらい前に作ったものです。平坦なシート状のロボットが、ピラミッド型になってまた平らなシートに戻り、今度はスペースシャトルになります。

すごく愛らしいです。10年経って私たちのグループのニンジャ折り紙ロボット研究者は、22名ほどになりましたが、新しい世代のロボガミができ少し効率的になってできることが増えました。

新世代のロボガミは、実用的な目的を果たします。例えばこのロボットでは、地形によって自動的に進み方を変えます。

地面が平らで乾いていれば、這って進みます。急に荒れた地形になると転がり始め同じロボットですがこうなります。

地形に応じて駆動装置の動かし方を変えるのです。障害物があれば跳び越えます。この動作では、それぞれの脚にエネルギーを蓄え、パチンコのように放っています。

体操技だってします。ジャーンプ。ロボガミが単体でどのように動くのかをご覧いただきました。

では、グループで行動したらどうでしょうか?もっと複雑な作業に力を合わせて取り組みます。

モジュールにはアクティブなもの。パッシブなものがあり、組み合わせて異なる形状を作り出せます。

それだけではなく関節を制御することで異なるタスクを作り、挑むことができ形が新たなタスク空間を作るのです。

ここで最重要なのは組み立てです。違った場所にいる相手を自動的に見つけ出す必要があり、環境と作業に応じてくっついたり離れたりします。

そしてもう実現できているのです。さて次はどうなるのか?想像力を働かせましょう。

これは、このタイプのモジュールで達成できることのシミュレーションです。

4本足で歩くものを作ろうと決め、よちよち歩く子犬にしました。同じモジュールで別のものを作ることもできます。

ロボットアームは典型的で古典的なロボットの用途です。ロボットアームで物体をつかみ上げられます。

更にモジュールを追加すれば、より大きなあるいはより小さな物体を掴み上げられるようロボットアームの腕を長くでき3本目の腕だって付けられます。

ロボガミには、決まった形状や作業はありません。いつでも、どこでも、どんな形状にも変形できるのです。

ではどのように製作するのでしょうか?

ロボガミ最大の技術的な課題は非常に薄くし、柔軟にしながら機能を維持することです。

多層の回路やモーターやマイクロコントローラーやセンサーをすべて本体内に持ち一つ一つの接合部を制御して指示通りに動きこんな柔らかな��きもできます。

一つの作業のためだけに作られたロボットとは違い、ロボガミは複数の作業をすることに最適化されています。

このことは、地球上の過酷で独特な環境や宇宙での作業で重要になります。

宇宙はロボガミにぴったりな環境です。

宇宙では、作業ごとに専用のロボットを用意する余裕はありません。宇宙では、どれほど多様な作業が必要になるかわかりません。様々な作業向けに変形するようなロボットが必要になります。

ロボガミのモジュール一式が、変形していくつもの作業をこなすようにしたいのです。

私だけが言っているわけではないですよ。このコンセプトに資金援助をしているのは欧州宇宙機関とスイス宇宙局だからです

ここにはロボガミのいろいろな構成のイメージが描かれていますが、異星の地表を探査するものもあれば、地面を掘っているものもあります。

探査だけではありません。宇宙飛行士にも手伝いが必要です。インターンを連れて行く余裕はありませんから。

宇宙飛行士はあらゆる退屈な作業をこなさねばなりません。単純な作業かもしれませんが、とてもインタラクティブです。ロボットに実験を手助けさせる必要があります。

コミュニケーションをとりながら宇宙飛行士を支援し、いろいろなところに張り付いて道具を支える3本目の腕となります。

でも、例えば宇宙ステーションの外側にいるロボガミをどう制御するのでしょうか?

このケースでは、ロボガミが宇宙ゴミを捕えている様子が描かれています。

目で見ながら操作できますが、感触を直接、宇宙飛行士の手に伝えられたらもっといいでしょう。

ロボット本体の他にも・・・操作で必要になるのは触覚デバイスです。

触覚インターフェイスが、手触りを再現します。ロボガミを使えばそれも可能です。

これは世界最小の触覚インターフェイスです。

指先に触感を再現することができます。ロボガミに巨視的な動きと微視的な動きをさせることで実現しました。

これを使うことで物体の大きさや物体の曲率やまっすぐさを感じられるだけでなく硬さや手触りも感じられるのです。

アレックスがこのインターフェイスを親指で操作しています。

そしてこのインターフェイスにVRゴーグルとコントローラーとを合わせると仮想現実はもはや仮想ではなくなり触れられる現実となります。

彼が見ている青、赤、黒のボールは、その色だけで区別されるものではなくなり青いゴムボール、赤いスポンジボール、黒いビリヤード球として感じられます。

すでに可能な技術です。ちょっとお見せしましょう。

これを一般の方の前でライブ公開するのは、本当に初めてでうまくいくといいのですが、ここに示すのは解剖学の人体図とロボガミの触覚インターフェイスです。

他の再構成可能なロボットと同様に複数の作業をします。マウスと同じように操作できるだけでなく触覚インターフェイスとして機能します。

たとえば物体のない白い背景部分では、何も触るものがないのでインターフェイスの反応は、とてもスムーズです。

マウスのように操作して肌や筋肉質の腕のほうに移動して上腕二頭筋や肩を触ってみましょう。固くなったのが、分かると思います。

もう少し調べてみましょう。胸郭に近づいてみましょう。肋骨の上か肋間筋の上かで柔らかくなったり固くなったりし、固さの違いを感じることができます。

本当ですよ。ご覧のように私の指に対して固いあるいは強い力で押し戻してきます。

動いていない表面についてお見せしましたが、動いているものに近づいたらどうでしょうか?

たとえば拍動する心臓ではどうでしょう?何か感じられるでしょうか?

自分の心臓の脈だって取れます。オンラインショッピングを楽しんでいる時にポケットに入れておけば、買おうとしているセーターの感触の違いやどんな柔らかさなのか?

カシミアかどうかも分かり、あるいは買おうとしているベーグルがどのくらいの固さかカリカリの程度も分かるのです。もうできるようになっています。

このロボット技術は皆さんの日常のニーズに合わせてパーソナライズされ適応できるよう進化しています。

再構成可能なこの独特なロボットは、視覚的でない直感的なインターフェイスをニーズに的確に合わせて提供するプラットフォームです。

そのようなロボットの姿はもはや映画で描かれるようなものではなく皆さんの望み通りのものになるのです。

ありがとうございました。

(個人的なアイデア)

Apple Vision Pro 2023の登場で・・・

チャットGPTが、ここに搭載されれば?

どうなる?

今後のインスピレーションに期待します。

健常者にも活用できれば、月面や宇宙空間のロボットを自宅からゲームのように操作するだけで賃金がもらえるような、一神教での労働の概念が変わるかもしれません。

Before 2022, this would not have been possible, but with Apple, Google, and Microsoft agreeing to expand the use of “passkey,” a passwordless authentication system…

2022年以前では、不可能だったが、Apple・Google・Microsoftがパスワードな しの認証システム「パスキー」の利用拡大に合意したことで・・・

…on the basis of high security and a high degree of privacy as well…

高いセキュリティと高度なプライバシーも基本にして・・・

…and if, as Ivan Pupilev says, all everyday objects have gesture interface capabilities…

イワン・プピレフの言うように日常的な物すべてにジェスチャーインターフェース機能を搭載していれば・・・

By integrating them with a common smart home standard, “Matter,” and making it possible to automatically connect to them by simply approaching them, assuming permission and authentication…

スマートホーム共通規格「Matter」で統合して近づけるだけで本人の許可、認証を前提とし自動接続できるようにすることで

It may be possible to customize even simple functions as complex functions by combining various devices in a stand-alone manner.

単体では、単純な機能でもさまざまな機器を組み合わせることで複雑な機能としてカスタマイズできるようにできるかもしれない。

In the past, OpenDoc, a technology developed by Apple to realize compound document and document-centered operation, was available.

かつて、OpenDoc(オープンドック)は、Appleが開発したコンパウンド・ドキュメントとドキュメント中心の操作実現する技術があったが

Can we extend this technology to shift from a document-centric to a gesture-centric interface?

これを拡張して、ドキュメント中心からジェスチャーインターフェース中心にできないだろうか?

If you want to work on a larger screen from your smartphone, iPhone, or iPad with a user interface by wearing the Oculus Dash or HoloLens from Oculus Quest

Oculus QuestにあるOculus DashやHoloLensなどを身につけることでユーザーインタフェースをスマートフォン、iPhone、iPadからもっと大きい画面で作業したい場合

It was usual to use a computer with a large screen, but now it is possible to use a huge screen! However, there were limits to the amount of money and placement of the display.

大画面のパソコンでというのが、普通でしたが、もっと、巨大な画面で!!という場合はディスプレイの金額的、配置場所にも限界がありました。

Virtual reality as the future of the holographic age, Virtual reality Virtual reality OS and its extension to the gesture interface center.

ホログラム時代の未来にあるものとして、Virtual reality バーチャルリアリティのOSとジェスチャーインターフェース中心への拡張

Seamlessly linked together, there will be no spatial limits, and you’ll be able to work in a small room with any number of huge, large screens that you can place anywhere in 360 degrees!

シームレスに連携させることで、空間的に限界は無くなり、小さな部屋でいくらでも巨大な大画面で360度どこにでも置いて作業できるようになります!!

For example, even if it is not possible to display 3D without wearing glasses like the gesture interface in the sci-fi movie “Iron Man”…

例えば、SF映画「アイアンマン」に出てくるジェスチャーインターフェイスのようにメガネをかけずに立体表示させるとまではいかないまでも

It may be possible to “make it look realistic by wearing special glasses” such as Oculus Dash and HoloLens in Oculus Quest, so…

Oculus QuestにあるOculus DashやHoloLensなど「特殊なメガネをかけることでリアルに見せる」ことはできそうなので・・・

It would be fun to display the setting panel of a simple function device that you touch through the special glasses as if it pops up from inside the device in CG in a hologram format (image: Genie Effect on Mac)

特殊なメガネを通して、触った単純な機能の機器の設定パネルをホログラム形式でCGで機器の中からポップアップするように表示してくれると楽しそう(イメージは、Macのジニーエフェクト)

警察比例の原則。

警察比例の原則。

警察比例の原則。

前提として、公人、有名人、俳優、著名人は知名度と言う概念での優越的地位の乱用を防止するため徹底追跡可能にしておくこと。

最近2023年から始まったジェネレーティブ人工知能の流行によって

ジェネレーティブ人工知能で作られたメディア(画像・映像など)が人々の目に触れる際には、情報源を開示するよう求めている(オープンAIなど10社が自主ガイドラインに署名した)

ヘンリー・マークラムの研究で脳のイメージが数値化されたデータから・・・

この膨大なデータをディープラーニングを搭載したジェネレーティブ人工知能に候補を複数映像化させる

こうすることでストーカーしかできない人工知能の問題を解消できる?かもしれない

憲法第19条にもあるように「内心の自由」正確に特定しないようにして

権力者の頭脳の中身をリアルタイムに複数映像化したことをチャットGPTに説明してもらう。

これは三つしかない内のひとつ。リカレント・ニューラル・ネットワークを使います。

この権力者の頭脳の中身をリアルタイムに映像化したことをニティシュ・パドマナバンの老眼鏡を含めた未来の自動オートフォーカス搭載メガネなどを用いて

特殊なメガネを通して、ホログラム形式でCGからポップアップ表示できる可能性もありそうです。

しかし

機械学習ディープラーニング物体検出データベースのことを「Darknet」と呼んでいます。

フェイフェイ・リー構築した機械学習ディープラーニング画像データベースのことを「ImageNet」と呼んでいます。

他には、今のところ、リカレント・ニューラルネット(RNN)フレームワークなど・・・

たった三つしかないのが2022年の現状です。

<おすすめサイト>

Apple Vision Pro 2023

キース・カークランド:触覚を使ってナビゲートしてくれるウェアラブル技術

インターステラー(字幕版)

ダニエレ・ウッド: 地球上の生活を向上するために宇宙技術をどう使えば良いか?

キャスリン・コールマン:国際宇宙ステーションでの暮らし

ロボットの宇宙空間での活用2019

スカイラー・ティビッツ: 世界を変える4Dプリンティング

<提供>

東京都北区神谷の高橋クリーニングプレゼント

独自サービス展開中!服の高橋クリーニング店は職人による手仕上げ。お手頃50ですよ。往復送料、曲Song購入可。詳細は、今すぐ電話。東京都内限定。北部、東部、渋谷区周囲。地元周辺区もOKです

東京都北区神谷のハイブリッドな直送ウェブサービス(Hybrid Synergy Service)高橋クリーニングFacebook版

#ジェイミー#ペイク#ロボット#宇宙#インター#ステラ#Apple#Vision#Pro#ステーション#VR#AR#Hololens#触覚#ジェスチャー#人工#知能#概念#NHK#zero#ニュース#発見#discover#discovery

0 notes

Text

VRタブレットPC内のFLジェスチャー

#ジェスチャー#タイマー#音楽#プレーヤー#ビデオ

これは、非タッチコントロール用のオーディオ/ビデオプレーヤーまたはストップウォッチです。

携帯電話のタッチスクリーンに触れることなく

タッチスクリーンから1m以上離れた場合でも

指ジェスチャーだけでも

オーディオ/ビデオプレーヤーを制御し、特定の曲/ビデオを選択できます。

0 notes

Photo

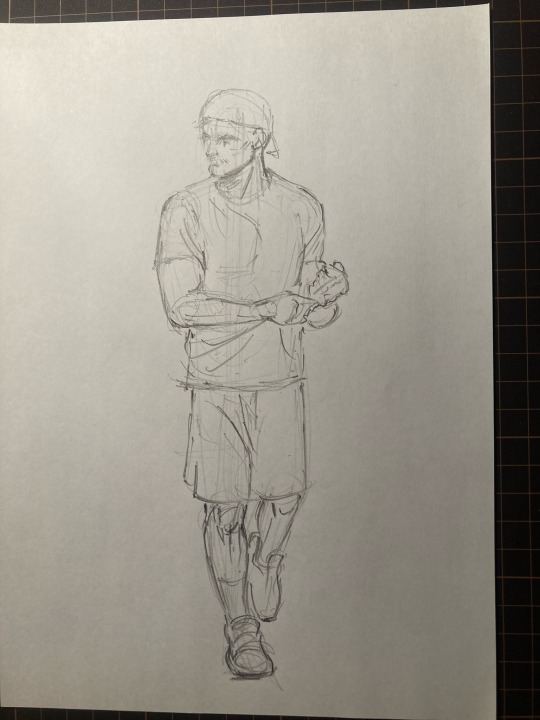

特別なジェスチャー。

ほうちゃん専用のジェスチャーです。

85 notes

·

View notes

Text

本日は【Romance of Bloom ~麗らかな春の約束~】イベントでした

ジェスチャーや書き書きやテレパシーで私の想い伝わったでしょうか?

間近で皆んなのコーディネートが見れて、想いが聞けて、こういったイベントはやっぱりいいなと思いました!

素敵な時間を共有出来て嬉しかったです♡

Mana

#mana-sama#mana#artemana#manasama#mana sama#moi meme moitie#malice mizer#artemena#guitar#punk#goth model#beautiful model#gothic#goth#moi dix mois#beutiful

102 notes

·

View notes

Text

OpenAIのCEOであるサム・アルトマンは、イーロン・マスク氏らとOpenAIを創業したひとりですが、米連邦議会で同社の株式は所有していない、と証言しています。しかし、アルトマンCEOはおカネがないから出資していないのではなく、ばく大な資産を別の会社に出資しています。日本人でも知っていそうな会社では、2020年まではソーシャルメディアのRedditの株式を所有(詳細未確認)していました。現在も所有していると思われる会社をいくつかリストにすると、以下のようになります。

・Helion Energy: 核融合発電所の建設

・Rain AI: 脳を模したエネルギー効率の高いAIチップ製造

・Neuralink: 脳コンピューター インターフェイス

・Humane: スマホ後のスマートデバイス

12月4日、OpenAIは上記の1社Rain AIのチップが販売できるようになった場合、5100万ドルぶんを購入する契約が成立した、と報じられました。一見すると、利益相反取引としか思えませんが、AIのコストとサム・アルトマンの投資先リストを眺めると、ひとつの世界観に基づくポートフォリオであることがわかります。

まず、一般ユーザーが手にするのはHumaneのスマートデバイスです。

AppleがiPhoneをマイナーチェンジしながら延命させているうちに、手のひらをディスプレイにして、ジェスチャーや音声でインターネットのサービスを利用できるデバイスが登場しています。

脳コンピューターインターフェイスの技術が確立すれば、ai pinのようなデバイスは脳に直結して、念じるだけで操作できるようになるはずです。「文字を読む」「声を発する」という非効率な方法ではなく、コンピューターの速度で人間も考えるようになります。

このとき、膨大なテキスト生成、画像生成が必要になるでしょう。いまのAIでは消費電力が多すぎて、低価格にサービスを提供できません。そこで、低消費電力のAI専用チップが必要になります。Rain AIとOpenAIの契約は、そういう背景で考えればOpenAIに大きなメリットがあります。

さらに、安価な電力を核融合発電所で生産できれば、ai pinのようなデバイスを非常に安価に提供でき、ライバルは太刀打ちできなくなります。そういう世界観の中で投資先を選んでいると考えれば、サム・アルトマンの構想がなんとなく見えてきます。

人工知能の電気代からわかるサム・アルトマンの先見性|K. Nakano

13 notes

·

View notes

Quote

セックスをコミュニケーションの手段として分析すると、その行為自体の内在的な本性と価値を見逃してしまう。セックスはたんなるジェスチャーでも一連のジェスチャーでもなく、実際のところ必ずしも他の目的のための手段ではなく、むしろそれ自体強烈な快をもたらす身体的活動である。言語が用いられるときには、シンボルはそれ自体では重要性をもたない。シンボルは単にそれによって伝達されるもののための乗り物にすぎない。さらに、言語の使用におけるスキルは、注意深く学習されなければならない技術的獲得物である。もしよりよいセックスが、より熟練したボディーランゲージによっていっそううまく伝達されるコミュニケーションであるならば、私たちはそのボキャブラリーや文法を学校で学ぶべきだということになるだろう。ソロモンの分析は、言語というメタファーを使うものだが、それによれば、セックスマニュアル的なアプローチが適切であるように見られる。それは、感覚と欲望に強制されることなく服従する自然な快楽を、ある種の技術的な能力に置き換えてしまうものだ。

翻訳ゲリラ:アラン・ゴールドマン「プレイン・セックス」 | 江口某の不如意研究室

8 notes

·

View notes

Photo

Xユーザーの煮干しさん: 「#菊地真_萩原雪歩_twinLive 悲藍ではすごく嬉しそうに 「ボクのグッズだ!!!☺️」って言ってくれて……… すごく………可愛かった………… 嬉しかった…………… 純愛ではめちゃくちゃジェスチャーしてくれた https://t.co/Al5xVZCI12」 / X

3 notes

·

View notes

Quote

人の名前を覚えることは、敬意と気配りを示す強力なジェスチャーです。記憶テクニックや連想法を利用して、思い出す力を高めます。

誰とでも会話を始める 50 の方法 | アマン・バティア著 | 中くらい

5 notes

·

View notes

Text

オシズカニ (Keep it down please)

1 note

·

View note

Text

youtube

Apple Vision Pro 2023

Appleがバーチャルリアリティをデザインするってこういうこと。

Macのドラック&ドロップをバーチャルリア��ティーで表現すると、このようになるということが示されている。

Apple Vision Proにより従来のディスプレイの枠を超えて広がるアプリのための無限のキャンバスを作り出し

ユーザーの目と手、声という、最も自然で直感的な操作方法によって、完全に3次元化されたユーザーインターフェイスを実現する。

オペレーティングシステムレベルから実現してます。

「Disey +」のコンテンツが、Apple Vision Pro内で縦横無尽に動き回ります。

他には、検査装置、医療機器の側面から見ると・・・

Apple Vision Proは、虹彩のアイトラッキングから脳の電気活動、心拍やリズム、筋肉活動、脳内血液密度、血圧、皮膚表面の電気抵抗といった信号を検出できる。

「好奇心」「迷ってる」「怖がっている」「注意を払っている」「過去の体験を思い出している」などのユーザーの認知状態を予測できるようになる?

Apple Vision Pro一つで将来、いくつかの検査が同時、及び、事前に可能になり虹彩認証で予測される結果をApple Watchのように目の前にアラート形式で表示してくれるかもしれない。

しかも、行政府や他社とは違い指紋認証や顔認証と同様に虹彩認証データはApple Vision Pro内で処理されて外部サーバーには送信されません。

パスキーにも対応しています。

あなたの許可を前提に提供してくれたデータは、現時点でAppleの場合、広告ではなくハードウェアの製品開発に使用してます。

屋外のスキーやスノーボードのゴーグルタイプだし、ゴーグルタイプの老眼用やメガネ、視力矯正や簡易的な視力検査装置にも!

幅広く活用できたら嬉しいですね。

そして

WWDCは「開発者向け」イベントなので、これまでのAppleの歴史からすると新市場を開拓していくため最初は高価格ってよくあること。

MacのXDR Displayを一つ挙げても70万円くらいだから高解像度の巨大なディスプレイが持ち運べると考えたらむしろ安く感じる。

さらに、開発環境も今までの蓄積があるため

Apple Vision Proにはデベロッパが開発したアプリやコンテンツが見つかる新しいApp Storeが用意されている。

iPhoneやiPadでお馴染みの数十万ものアプリもスムーズに動作し、Vision Proのために開発された新しい入力操作システムと自動的に連係します。

また、さらに一歩進んで、Vision ProとvisionOSのパワフルかつユニークな機能を活かし、これまでにないアプリ体験を一からデザインしたり

これまでの既存のアプリを空間コンピューティングに合わせて再構築できます。

2023年時のApple製品には「eSIM」も標準で搭載してるので・・・

屋外で使用できることも考えているなら・・・

Apple Vision Proにも搭載してると思ってます。

もし搭載していなくてもApple製品のMacに既に実現している標準機能をApple Vision Proに拡張機能追加か何かで反映すれば通話情報を転送することもできます。

屋内だけなら車の運転を行いながらナビゲートしてくれる「Car Play」の上位機種としてバーチャルリアリティで目前のリアルタイムナビゲートもソフトウェアで実現できそう。

ハンドルを握りながら指をタップするだけで通話や音声入力できるし、手を離さなくても視線を向けるだけで選択してくれるMacに既に搭載している

障害者用の「アクセシビリティ」機能のバーチャルリアリティ版も見た感じだけど将来はできそうなVisionがきます。

(個人的なアイデア)

Apple Vision Pro 2023の登場で・・・

チャットGPTが、ここに搭載されれば?

どうなる?

今後のインスピレーションに期待します。

健常者にも活用できれば、月面や宇宙空間のロボットを自宅からゲームのように操作するだけで賃金がもらえるような、一神教での労働の概念が変わるかもしれません。

Before 2022, this would not have been possible, but with Apple, Google, and Microsoft agreeing to expand the use of “passkey,” a passwordless authentication system…

2022年以前では、不可能だったが、Apple・Google・Microsoftがパスワードな しの認証システム「パスキー」の利用拡大に合意したことで・・・

…on the basis of high security and a high degree of privacy as well…

高いセキュリティと高度なプライバシーも基本にして・・・

…and if, as Ivan Pupilev says, all everyday objects have gesture interface capabilities…

イワン・プピレフの言うように日常的な物すべてにジェスチャーインターフェース機能を搭載していれば・・・

By integrating them with a common smart home standard, “Matter,” and making it possible to automatically connect to them by simply approaching them, assuming permission and authentication…

スマートホーム共通規格「Matter」で統合して近づけるだけで本人の許可、認証を前提とし自動接続できるようにすることで

It may be possible to customize even simple functions as complex functions by combining various devices in a stand-alone manner.

単体では、単純な機能でもさまざまな機器を組み合わせることで複雑な機能としてカスタマイズできるようにできるかもしれない。

In the past, OpenDoc, a technology developed by Apple to realize compound document and document-centered operation, was available.

かつて、OpenDoc(オープンドック)は、Appleが開発したコンパウンド・ドキュメントとドキュメント中心の操作実現する技術があったが

Can we extend this technology to shift from a document-centric to a gesture-centric interface?

これを拡張して、ドキュメント中心からジェスチャーインターフェース中心にできないだろうか?

If you want to work on a larger screen from your smartphone, iPhone, or iPad with a user interface by wearing the Oculus Dash or HoloLens from Oculus Quest

Oculus QuestにあるOculus DashやHoloLensなどを身につけることでユーザーインタフェースをスマートフォン、iPhone、iPadからもっと大きい画面で作業したい場合

It was usual to use a computer with a large screen, but now it is possible to use a huge screen! However, there were limits to the amount of money and placement of the display.

大画面のパソコンでというのが、普通でしたが、もっと、巨大な画面で!!という場合はディスプレイの金額的、配置場所にも限界がありました。

Virtual reality as the future of the holographic age, Virtual reality Virtual reality OS and its extension to the gesture interface center.

ホログラム時代の未来にあるものとして、Virtual reality バーチャルリアリティのOSとジェスチャーインターフェース中心への拡張

Seamlessly linked together, there will be no spatial limits, and you’ll be able to work in a small room with any number of huge, large screens that you can place anywhere in 360 degrees!

シームレスに連携させることで、空間的に限界は無くなり、小さな部屋でいくらでも巨大な大画面で360度どこにでも置いて作業できるようになります!!

For example, even if it is not possible to display 3D without wearing glasses like the gesture interface in the sci-fi movie “Iron Man”…

例えば、SF映画「アイアンマン」に出てくるジェスチャーインターフェイスのようにメガネをかけずに立体表示させるとまではいかないまでも

It may be possible to “make it look realistic by wearing special glasses” such as Oculus Dash and HoloLens in Oculus Quest, so…

Oculus QuestにあるOculus DashやHoloLensなど「特殊なメガネをかけることでリアルに見せる」ことはできそうなので・・・

It would be fun to display the setting panel of a simple function device that you touch through the special glasses as if it pops up from inside the device in CG in a hologram format (image: Genie Effect on Mac)

特殊なメガネを通して、触った単純な機能の機器の設定パネルをホログラム形式でCGで機器の中からポップアップするように表示してくれると楽しそう(イメージは、Macのジニーエフェクト)

警察比例の原則。

警察比例の原則。

警察比例の原則。

前提として、公人、有名人、俳優、著名人は知名度と言う概念での優越的地位の乱用を防止するため徹底追跡可能にしておくこと。

最近2023年から始まったジェネレーティブ人工知能の流行によって

ジェネレーティブ人工知能で作られたメディア(画像・映像など)が人々の目に触れる際には、情報源を開示するよう求めている(オープンAIなど10社が自主ガイドラインに署名した)

ヘンリー・マークラムの研究で脳のイメージが数値化されたデータから・・・

この膨大なデータをディープラーニングを搭載したジェネレーティブ人工知能に候補を複数映像化させる

こうすることでストーカーしかできない人工知能の問題を解消できる?かもしれない

憲法第19条にもあるように「内心の自由」正確に特定しないようにして

権力者の頭脳の中身をリアルタイムに複数映像化したことをチャットGPTに説明してもらう。

これは三つしかない内のひとつ。リカレント・ニューラル・ネットワークを使います。

この権力者の頭脳の中身をリアルタイムに映像化したことをニティシュ・パドマナバンの老眼鏡を含めた未来の自動オートフォーカス搭載メガネなどを用いて

特殊なメガネを通して、ホログラム形式でCGからポップアップ表示できる可能性もありそうです。

しかし

機械学習ディープラーニング物体検出データベースのことを「Darknet」と呼んでいます。

フェイフェイ・リー構築した機械学習ディープラーニング画像データベースのことを「ImageNet」と呼んでいます。

他には、今のところ、リカレント・ニューラルネット(RNN)フレームワークなど・・・

たった三つしかないのが2022年の現状です。

<おすすめサイト>

ニティシュ・パドマナバン:老眼鏡を含めた未来の自動オートフォーカス搭載メガネ

ロボットの宇宙空間での活用2019

キース・カークランド:触覚を使ってナビゲートしてくれるウェアラブル技術

イワン・プピレフ:身の回りのものすべてがインターフェイスになる

0 notes

Photo

New Post has been published on https://fox-info.net/fox-photo/archives/25729

ジェスチャー子ぎつね

これくらいだった!🦊

9 notes

·

View notes

Text

VRタブレットPC内のFLジェスチャー

#ジェスチャー#タイマー#音楽#プレーヤー#ビデオ

これは、非タッチコントロール用のオーディオ/ビデオプレーヤーまたはストップウォッチです。

携帯電話のタッチスクリーンに触れることなく

タッチスクリーンから1m以上離れた場合でも

指ジェスチャーだけでも

オーディオ/ビデオプレーヤーを制御し、特定の曲/ビデオを選択できます。

0 notes